A pesar de que ya llevamos muchos años hablando sobre la Inteligencia Artificial, es una tecnología que todavía sigue en constante desarrollo y, de hecho, los esfuerzos de las grandes empresas parecen estar bastante centrados en ella. En un artículo publicado en la revista científica Nature, nos cuentan que los científicos de Google Brain han introducido una nueva técnica de aprendizaje por refuerzo profundo cambiando la colocación de diferentes componentes en sus chips para IA, y ha desvelado que la IA y la humanidad tienen unas grandes sinergias.

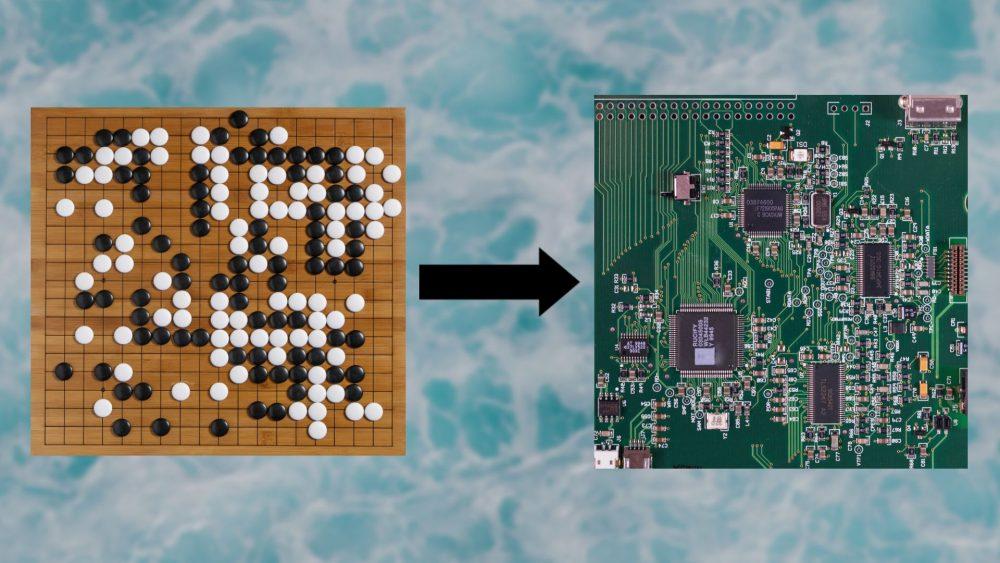

Según la publicación, los investigadores de Google lograron utilizar una técnica de aprendizaje por refuerzo para diseñar la próxima generación de TPUs (Tensor Processing Units), los procesadores de Inteligencia Artificial especializados de Google. Esto significa que los próximos chips de IA del gigante de Internet estarán diseñados por la anterior generación de chips de IA de la firma.

La Inteligencia Artificial que diseña chips para IA

El uso de software en el diseño de chips no es algo nuevo, pero según los investigadores de Google el nuevo modelo de aprendizaje por refuerzo «genera automáticamente planos de planta de chips que son superiores o comparables a los producidos por humanos en todas las métricas clave, incluyendo consumo de energía, rendimiento y área del chip». Y lo mejor de todo es que lo hace en una fracción del tiempo que tardaría un humano en hacerlo.

La superioridad de la IA sobre el desempeño humano ha atraído mucha atención; un medio de comunicación lo describió como «software de Inteligencia Artificial que puede diseñar chips más rápido que los humanos» y escribió que «un chip que a los humanos les tomaría meses diseñar puede ser ideado por la IA de Google en menos de seis horas». Pero leyendo el artículo de Nature, lo que sorprende no es la complejidad del sistema utilizado para diseñar los chips, sino la sinergia que hay entre la inteligencia humana y la artificial.

Analogías, intuición y recompensas

El documento describe el problema como tal: «La planificación del diseño de chips implica colocar listas de redes en lienzos de chips (cuadrículas bidimensionales) para que las métricas de rendimiento (por ejemplo el consumo de energía, el tiempo, área y longitud de las conexiones) se optimicen, mientras que se adhieren a las estrictas restricciones de densidad y congestión de rutas».

Básicamente, lo que se quiere hacer es colocar los componentes de la manera más óptima y, sin embargo, como en cualquier otro problema a medida que aumenta la cantidad de componentes internos del chip, encontrar diseños óptimos se vuelve más complicado. Esto es precisamente lo que la IA parece haber solucionado o, al menos, mitigado.

El software existente ayuda a acelerar el proceso de descubrimiento de disposiciones de los chips, pero se queda corto cuando el chip aumenta su complejidad. Los investigadores decidieron extraer experiencia de la forma en que el aprendizaje por refuerzo ha resuelto otros problemas complejos, y esta es la manifestación de uno de los aspectos más importantes y complejos de la inteligencia humana: la analogía.

Los humanos podemos extraer abstracciones de un problema que resolvemos y luego aplicarlas a otros problemas. Si bien damos por sentado estas habilidades, son lo que nos hace muy buenos en el aprendizaje por transferencia, y esta es la razón por la que los investigadores pudieron replantear el problema de la planificación del diseño de chips como si fuera un juego de mesa.

Los modelos de aprendizaje por refuerzo profundo pueden ser especialmente buenos para buscar espacios muy grandes, una hazaña que es físicamente imposible con el poder de cómputo del cerebro. No obstante, los científicos resolvieron el problema con una red neuronal artificial que podía codificar diseños de chips como representaciones vectoriales y facilitaron mucho la exploración del espacio del problema. Según el documento, «nuestra intuición fue que en una política capaz de la tarea general de la colocación de los chips también debería ser posible codificar el estado asociado con un nuevo chip invisible en una señal significativa en el momento de la inferencia. Por lo tanto, entrenamos una arquitectura de red neuronal capaz de predecir la recompensa en la colocación de nuevas listas de red con el objetivo final de utilizar esta arquitectura como la capa codificadora de nuestra política».

El término intuición se utiliza a menudo de manera vaga, pero es en realidad un proceso muy complejo y poco entendido que involucra experiencia, conocimiento inconsciente, reconocimiento de patrones y muchos más factores. Nuestras intuiciones provienen de años de trabajo en un campo, pero también pueden obtenerse de experiencias en otras áreas. Por fortuna, poner a prueba estas intuiciones es cada vez más fácil con la ayuda de herramientas de aprendizaje automático y computación de alta potencia.

También vale la pena señalar que los sistemas de aprendizaje por refuerzo necesitan una recompensa bien diseñada. De hecho, algunos científicos creen que con la función de recompensa adecuada, el aprendizaje por refuerzo es suficiente para alcanzar a la inteligencia artificial general y, sin embargo, sin la recompensa adecuada un agente de RL puede atascarse en bucles sin fin.

litteranova.com Filosofía, ciencia, artes y saberes

litteranova.com Filosofía, ciencia, artes y saberes